| Spark sql通过 jdbc 连接MySQL数据库报错:java.sql.SQLException: Access denied for user ‘root‘@‘localhost‘ (usin | 您所在的位置:网站首页 › 连接数据库报错access denied › Spark sql通过 jdbc 连接MySQL数据库报错:java.sql.SQLException: Access denied for user ‘root‘@‘localhost‘ (usin |

Spark sql通过 jdbc 连接MySQL数据库报错:java.sql.SQLException: Access denied for user ‘root‘@‘localhost‘ (usin

|

(1)连接准备

1.在这之前要将mysql-connector-java-5.1.40.tar.jar.gz解压到spark的jars目录下

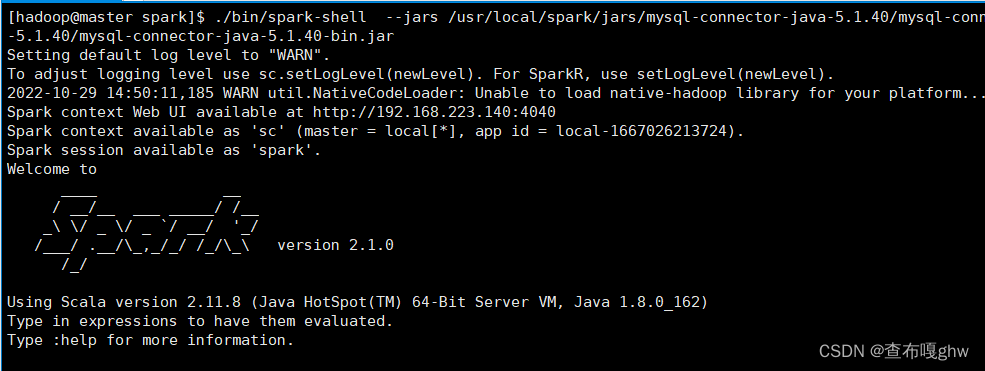

然后启动Hadoop和spark的相关进程,以及MySQL服务。 进入到spark文件夹下通过下面命令启动spark: [hadoop@master spark]$ ./bin/spark-shell \ > --jars /usr/local/spark/jars/mysql-connector-java-5.1.40/mysql-connector-java-5.1.40-bin.jar \ > --driver-class-path /usr/local/spark/jars/mysql-connector-java-5.1.40/mysql-connector-java-5.1.40-bin.jar

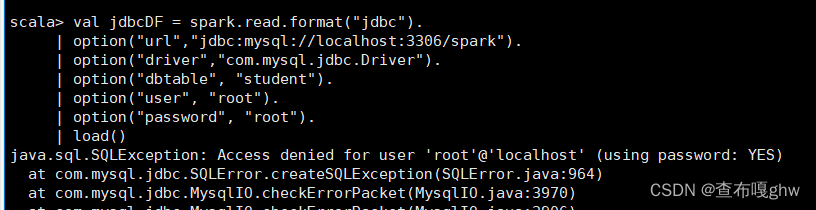

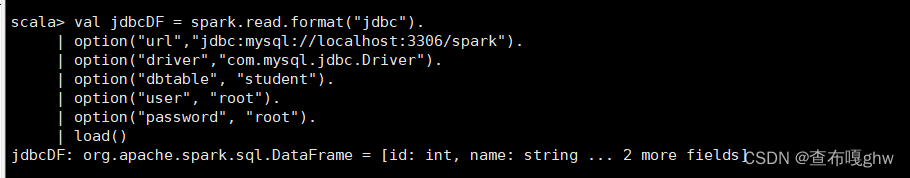

再在spark-shell中通过下面命令连接MySQL (2)错误:通过下列命令远程连接MySQL: scala> val jdbcDF = spark.read.format("jdbc"). | option("url","jdbc:mysql://localhost:3306/spark"). //数据库的连接地址 | option("driver","com.mysql.jdbc.Driver"). //数据库的jdbc驱动程序 | option("dbtable", "student"). //所要访问的表 | option("user", "root"). //数据库用户名 | option("password", "root"). //数据库密码 | load()

用户“root”@“本地主机”的访问被拒绝(使用密码:是) 需要root@localhost开启远程访问权限。 进入数据库: 。。。。。。。。 通过命令开启MySQL远程访问权限: 授权用户root, 设定密码为root 只允许IP地址为192168.223.140(我的虚拟机的IPADDR)可远程连接到MySQL的所有数据库: mysql> grant all privileges on *.* to 'root'@'192.168.223.140' identified by 'root' with grant option; 2.但是:报错:

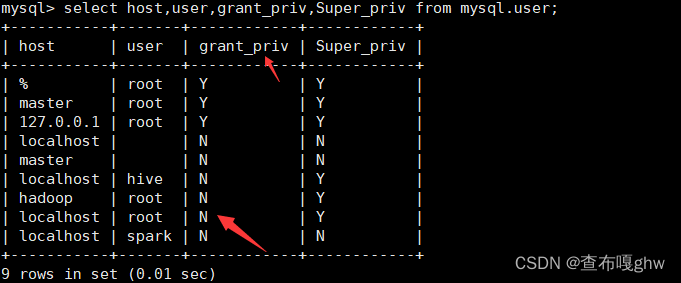

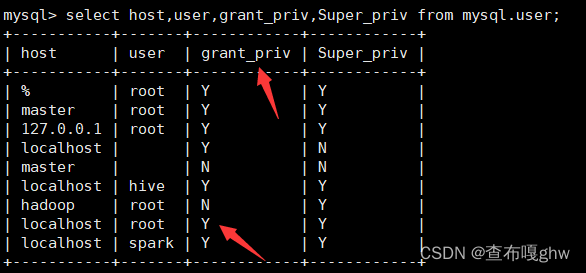

原来是我的root@localhost没有开启远程访问权限的权限 查询当今用户:要先确定自己是用哪个用户登录的MySQL!!! mysql> select user();通过命令查看一下权限问题: mysql> select host,user,grant_priv,Super_priv from mysql.user;

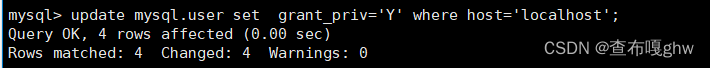

发现我的root@localhost的grant_priv 权限是NO (3)解决方法: 1.通过命令更改root@localhost的grant_priv 权限为Y(yes) mysql> update mysql.user set grant_priv='Y' where host='localhost';

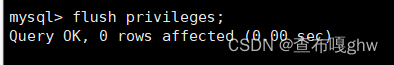

如上图所示已更改完成!!! 5.root@localhost开启远程连接的权限: mysql> grant all privileges on *.* to 'root'@'192.168.223.140' identified by 'root' with grant option; mysql> flush privileges; 6.在Spark-shell中再次执行连接命令。

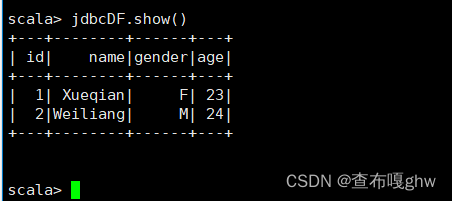

查看数据表: scala> jdbcDF.show()

|

【本文地址】

公司简介

联系我们